Am heutigen Donnerstag veröffentlichte das amerikanische Patent- und Markenamt ein nun bewilligtes Patent von Apple. Dieses beschreibt eine neue Methode der sicheren drahtlosen Kommunikation von Apple Geräten.

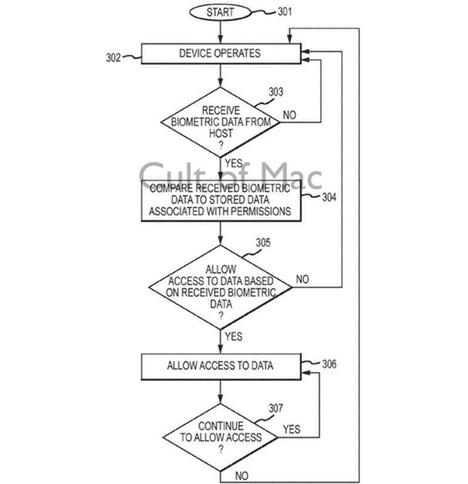

Ziel des Systems ist ein sicherer Verbindungsaufbau von Apple Geräten untereinander. Für die Authentifizierung sollen hierbei mehrere biometrische Erkennungszeichen herangezogen werden. Während Apple mit dem iPhone 5S den Fingerabdruck als Sicherheitsabfrage einführte, soll die neue Technik Merkmale, wie Gesichts-, Stimmen- und eine Iriserkennung miteinbeziehen. Die erfolgreiche Sicherheitsüberprüfung ist Voraussetzung für einen uneingeschränkten Datenaustausch von Macs und iOS Geräten. Anschließend sollen Dateifreigaben und weitere Dienste zur Verfügung stehen.

Damit nicht bei jedem Verbindungsaufbau alle Authentifizierungsschritte vorgenommen werden müssen, unterscheidet das System zwischen verschiedenen Sicherheitsstufen. Somit könnte der Zugriff auf private Dateien nur durch einem zusätzlichen Irisscan erfolgen, während die allgemein freigegebenen Daten schon durch eine erfolgreiche Gesichtserkennung zugänglich sind.

Die Patentschrift “Wireless Pairing and Communication Between Devices Using Biometric Data“ wurde von Apple am 31. August 2012 eingereicht. (via)

Sie sehen gerade einen Platzhalterinhalt von Facebook. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Instagram. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

Ich hoffe nur, dass über diesen Weg nicht alle relevanten persönlichen Daten irgendwann bei Bundesbehörden (NSA) ect. gelangen. Der gläserne Mensch mit all seinen persönlichen Merkmalen ist im Vormarsch.

Ich hoffe nur, dass sich nicht irgendwann herausstellt, dass die Scans der Iris auf Dauer schädlich für die Augen sind.

Ich hoffe nur, dass ich nicht stolpere wenn ich gleich irgendwohin laufe.

Wer so „kurzsichtig“ denkt, dem wird das mit Sicherheit passieren.

das Problem ist ja, dass NSA&Co die biometrischen Daten schon haben. Krankenakten, Fingerabdrücke vom iPhone, Gesichtsscans vom neuen Perso (Auftrag wurde via CSC abgewickelt, Unterfirma der NSA).

D.h. sie wollen garnicht neue Daten (die haben sie schon) oder die Kryptosicherheoit erhöhen (wenn sie die Daten haben, können sie sie auch via „man in the middle“ simulieren). Es geht darum, sicher zu wissen, wer gerade mit wem über was spricht und wer gerade was tut.