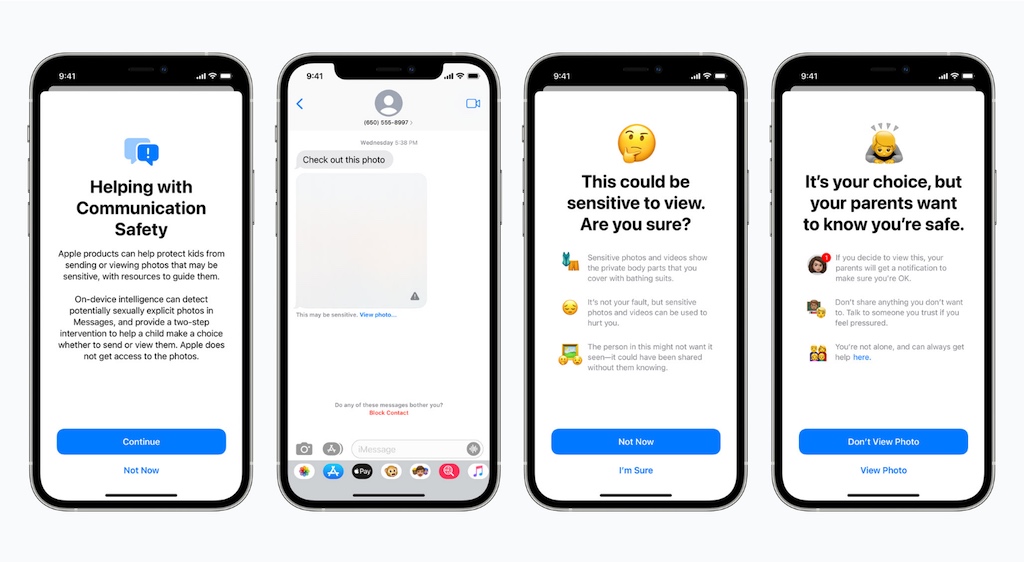

Apple hat diese Woche eine neue Initiative vorgestellt, die dem Schutz von Kindern dienen soll. Die Initiative „Expanded Protections for Children“ (Erweiterter Schutz für Kinder) besteht aus mehreren Elementen, die jeweils in die wichtigsten Apple-Plattformen integriert werden. Hierbei sorgte eine neue Funktion, die iCloud-Fotobibliotheken auf kinderpornografische Inhalte (CSAM, Child Sexual Abuse Material) untersucht, für Bedenken. Nun meldet sich Apple erneut zu Wort und geht auf die Bedenken ein.

Fotocredit: Apple

Auf den Datenschutz bedachte Scan-Funktion

Apple hat gegenüber MacRumors einige Kommentare bezüglich der neuen Schutzfunktionen für Kinder gegeben und geht bei der Gelegenheit auf die geäußerten Bedenken ein. Konkret geht es um das Scannen von Fotos im Rahmen des erweiterten Schutzes für Kinder. Hierbei werden iCloud-Fotobibliotheken auf kinderpornografische Inhalte untersucht.

Wie Apple versichert, ist das System auf den Datenschutz bedacht. Anstatt Bilder in der Cloud auf bestimmte Merkmale zu scannen, wird das System einen Hash-Abgleich mit einer Datenbank bekannter CSAM-Bilder durchführen. Die Hash-Technologie, NeuralHash genannt, analysiert ein Bild und wandelt es in eine eindeutige Nummer um, die für dieses Bild spezifisch ist. Die Werte werden anschließend verglichen. Der Hauptzweck des Hashes ist es, sicherzustellen, dass identische und visuell ähnliche Bilder den gleichen Hash ergeben, während Bilder, die sich voneinander unterscheiden, unterschiedliche Hashes ergeben.

Erweiterung des Systems auf Länderbasis

Apples CSAM-Erkennungssystem wird bei der Markteinführung auf die USA beschränkt sein. Gegenüber MacRumors bestätigte das Unternehmen, dass das System auch auf andere Länder ausgeweitet werden kann. Hierfür wäre jedoch eine rechtliche Bewertung für jedes Land erforderlich. Apple hat keinen Zeitrahmen für die weltweite Ausweitung des Systems genannt, falls ein solcher Schritt jemals erfolgen sollte.

False Positives und mögliche Ausnutzung des Systems

Bedenken, dass ein Nutzer fälschlicherweise wegen unangemessenen Bildmaterials markiert wird, sogenannte „False Positives“, hat Apple nicht. Das System soll sehr genau sein, mit einer extrem niedrigen Fehlerquote von weniger als einem von einer Billion Konten pro Jahr. Zudem erklärt das Unternehmen, dass es einen Schwellenwert gibt, bevor ein Nutzer markiert wird. Selbst wenn der Schwellenwert überschritten wird, dient ein manuelles Überprüfungsverfahren von Apple als zusätzliche Absicherung. Dennoch können Nutzer, die Bedenken wegen Apples Bemühungen haben, iCloud-Fotos deaktivieren. So werden bekannte CSAM-Bilder nicht erkannt, wenn die iCloud-Fotos-Funktion ausgeschaltet ist.

Eine der häufigsten geäußerten Bedenken betrifft die Frage, was passieren könnte, wenn andere Regierungen versuchen, dieses System für andere Zwecke zu nutzen. Apple bekräftigte seine Bemühungen, dieses neue System ausschließlich als Mittel zur Erkennung von CSAM zu verwenden, und nicht mehr. Das Unternehmen räumte jedoch ein, dass es keine „Patentlösung“ gibt, wenn es darum geht, dass das System möglicherweise missbraucht werden könnte.

Sie sehen gerade einen Platzhalterinhalt von Facebook. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Instagram. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

0 Kommentare