Apples Ankündigung des erweiterten Schutzes für Kinder (Expanded Protections for Children) hat merklich Wellen geschlagen. Dabei handelt es sich um eine Reihe von Funktionen, die Kinder vor sexuell eindeutigen Bildern bewahren und eine Verbreitung von Material über sexuellen Kindesmissbrauch (CSAM, Child Sexual Abuse Material) eindämmen sollen. Während einige glauben, dass die zunächst in den USA eingeführte Schutzmaßnahme eine großartige Sache ist, haben manche Nutzer Datenschutzbedenken. Nachdem sich Apple vor kurzem mit einem FAQ-Dokument dem Thema ausführlich gewidmet hatte, wurde nun eine Fragerunde für Reporter abgehalten. Hierbei erklärte Apple unter anderem, dass die Schutzmaßnahme auch auf Apps von Drittanbietern ausgeweitet werden könnte.

Fotocredit: Apple

Mögliche Erweiterung auf Apps von Drittanbietern

Während Apple auf viele der bereits bekannten Informationen genauer eingegangen ist, gab die Fragerunde auch einige neue Erkenntnisse. So sagte Apple, dass man heute zwar nichts anzukündigen habe, aber eine Ausweitung der Kindersicherheitsfunktionen auf Drittanbieter-Apps ein wünschenswertes Ziel sei. Apple nannte keine konkreten Beispiele, aber eine Möglichkeit wäre, dass die Kommunikations-Sicherheitsfunktion für Apps wie Snapchat, Instagram oder WhatsApp verfügbar gemacht wird. Eine weitere Möglichkeit ist, dass Apples CSAM-Erkennungssystem auf Drittanbieter-Apps ausgeweitet wird, die Fotos an anderer Stelle als iCloud-Fotos hochladen.

Apple gab keinen Zeitrahmen an, wann die Kindersicherheitsfunktionen auf Drittanbieter ausgeweitet werden könnten, da das Unternehmen die Tests und den Einsatz der Funktionen noch abschließen muss. Apple sagte auch, dass man sicherstellen müsse, dass eine mögliche Ausweitung die Privatsphäre-Eigenschaften oder die Effektivität der Funktionen nicht untergraben würde.

Ob und wann die neuen Funktionen Drittanbieter nutzen können, ist somit noch offen. Im Großen und Ganzen sei die Ausweitung von Funktionen für Drittanbieter jedoch der allgemeine Ansatz von Apple, und zwar seit der Einführung des App Store im Jahr 2008.

Apple erklärt die neuen Schutzfunktionen für Kinder

Ansonsten hat sich Apple im Zuge der Fragerunde den neuen Kindersicherheits-Tools im Allgemeinen gewidmet und gab einen Einblick in die Funktionsweise. Nachfolgend die wichtigsten Informationen der Veranstaltung:

Apple hat drei neue Kindersicherheitsfunktionen vorgestellt, die in zukünftigen Versionen von iOS 15, iPadOS 15, macOS Monterey und watchOS 8 enthalten sein werden. Zunächst werden die Funktionen nur in den USA verfügbar sein. Apple will prüfen, in welchen weiteren Ländern eine Einführung möglich ist.

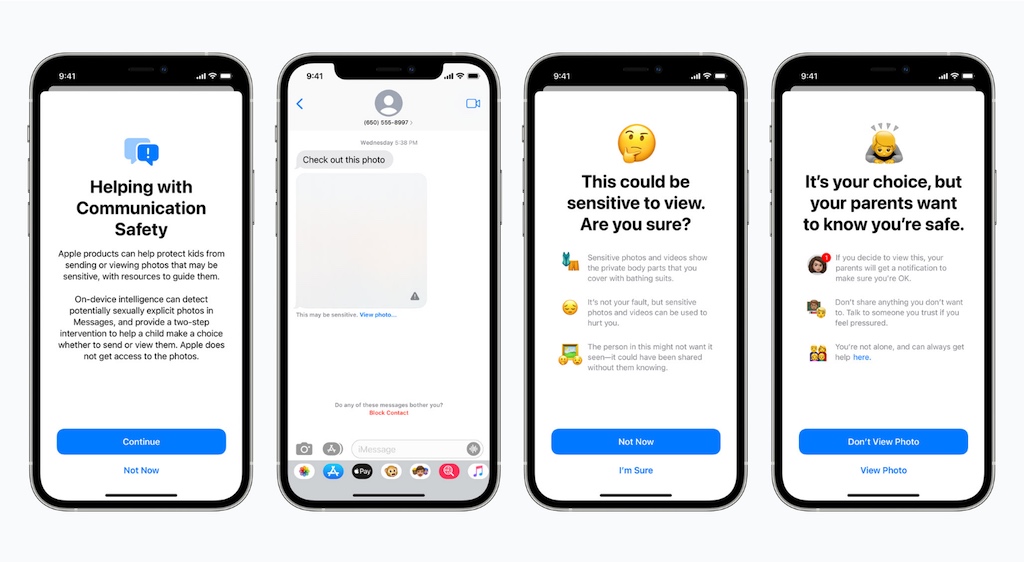

Erstens kann eine optionale Funktion für die Kommunikationssicherheit in der Nachrichten-App auf iPhone, iPad und Mac Kinder und ihre Eltern warnen, wenn sie sexuell eindeutige Fotos empfangen oder senden. Wenn die Funktion aktiviert ist, wird die Nachrichten-App laut Apple maschinelles Lernen auf dem Gerät verwenden, um Bildanhänge zu analysieren. Wenn ein Foto als sexuell explizit eingestuft wird, wird das Foto automatisch unscharf dargestellt und das Kind wird gewarnt.

Zweitens wird Apple in der Lage sein, bekannte CSAM-Bilder, die in iCloud-Fotos gespeichert sind, zu erkennen. Wie das Unternehmen nochmals bestätigte, ist das System auf den Datenschutz bedacht. Anstatt Bilder in der Cloud auf bestimmte Merkmale zu scannen, wird das System einen Hash-Abgleich mit einer Datenbank bekannter CSAM-Bilder durchführen. Apple bestätigte auch, dass dieser Prozess nur für Fotos gilt, die in iCloud-Fotos hochgeladen werden, und nicht für Videos.

Wird eine bestimmte Anzahl von Übereinstimmungen festgestellt, erfolgt eine weitere Prüfung eines Mitarbeiters. Ergibt die zweite Prüfung das gleiche Ergebnis, meldet Apple diese Fälle an das National Center for Missing and Exploited Children (NCMEC), eine gemeinnützige Organisation, die mit den amerikanischen Strafverfolgungsbehörden zusammenarbeitet. Apple macht auch darauf aufmerksam, dass der Besitz von CSAM-Bildern in den meisten Ländern, auch in den USA, illegal ist.

Drittens wird Apple die Hinweise in Siri und der Spotlight-Suche geräteübergreifend erweitern und zusätzliche Ressourcen bereitstellen, die Kindern und Eltern dabei helfen, sicher im Internet zu bleiben und Hilfe in unsicheren Situationen zu erhalten. So werden Nutzer, die Siri fragen, wie sie CSAM oder die Ausbeutung von Kindern melden können, auf Ressourcen verwiesen, die ihnen zeigen, wo und wie sie eine Meldung machen können.

(via MacRumors)

Sie sehen gerade einen Platzhalterinhalt von Facebook. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Instagram. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

0 Kommentare