US Kolumnist Steven Levy hatte die Möglichkeit, mit den Apple Managern Eddy Cue, Craig Federighi, Phil Schiller sowie zwei Siri-Ingenieuren über den mobilen Sprachassistenten aus Cupertino zu sprechen. Insbesondere ging es dabei um die Verbesserungen, die Siri in den letzten Jahren durch maschinelles Lernen erlangt hat.

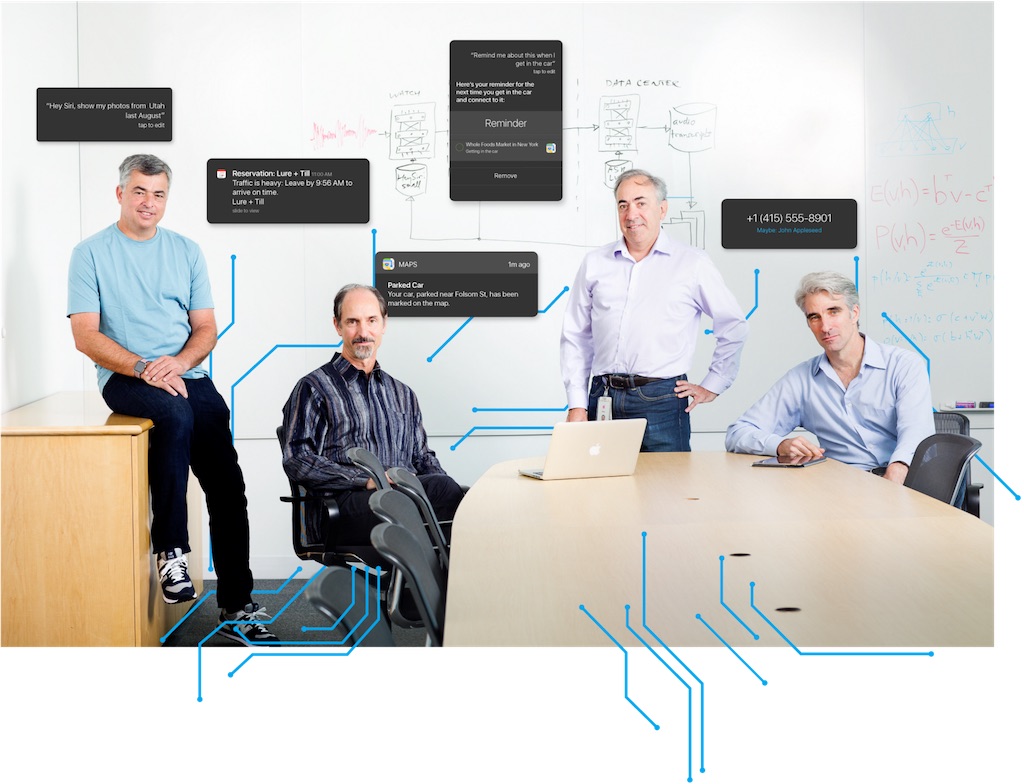

Eddy Cue, Craig Federighi und Co. sprechen über Siri

Mit iOS 10 wird Apple Siri weiter verbessern. Unter anderem öffnet Apple Siri für Entwickler, so dass auch Drittanbieter-Apps auf Siri setzen können. Ein paar der interessantesten Auszüge des Interviews haben wir für euch zusammengetragen.

Am 30. Juli 2014 hat Apple Siri ein großes Update spendiert. Dabei setzt Apple auf ein sogenanntes „neural-net based System“. Das Siri Backend wurde in diesem Zusammenhang komplett überarbeitet, was zu einer deutlich besseren Präsentation führte. Eddy Cue gab zu verstehen dass sich die Fehlerquote halbiert habe. Die Testergebnisse waren so beeindruckend, dass man die Tests wiederholt habe, da man die Ergebnisse zunächst nicht glauben konnte.

“The error rate has been cut by a factor of two in all the languages, more than a factor of two in many cases,” says Acero. “That’s mostly due to deep learning and the way we have optimized it — not just the algorithm itself but in the context of the whole end-to-end product.”

Zur Verbesserung von Siri habe man an allen Ecken und Kanten geschraubt (Hardware, Software, Position der Mikrofone etc.). Craig Federighi erklärt wie folgt

„It’s not just the silicon,“ adds Federighi. „It’s how many microphones we put on the device, where we place the microphones. How we tune the hardware and those mics and the software stack that does the audio processing. It’s all of those pieces in concert. It’s an incredible advantage versus those who have to build some software and then just see what happens.“

Das Maschinelle Lernen geht weit über Siri hinaus. Unbekannte Telefonnummern werden beim Klingeln des iPhone einer Person zusortiert, wenn euch diese zum Beispiel schonmal eine Mail geschickt hat, iOS 10 merkt sich euren Parkplatz, ihr werdet auch an Termine erinnert, die in einer Mail genannt werden und nicht in den Kalender eingetragen wurden etc.

You see it when the phone identifies a caller who isn’t in your contact list (but did email you recently). Or when you swipe on your screen to get a shortlist of the apps that you are most likely to open next. Or when you get a reminder of an appointment that you never got around to putting into your calendar. Or when a map location pops up for the hotel you’ve reserved, before you type it in. Or when the phone points you to where you parked your car, even though you never asked it to. These are all techniques either made possible or greatly enhanced by Apple’s adoption of deep learning and neural nets.

Auch bei Apple Pencil setzt Apple auf maschinelles Lernen, um die verschiedenen Eingabe-Stile zu erkennen.

In order for Apple to include its version of a high-tech stylus, it had to deal with the fact that when people wrote on the device, the bottom of their hand would invariably brush the touch screen, causing all sorts of digital havoc. Using a machine learning model for “palm rejection” enabled the screen sensor to detect the difference between a swipe, a touch, and a pencil input with a very high degree of accuracy. “If this doesn’t work rock solid, this is not a good piece of paper for me to write on anymore — and Pencil is not a good product,” says Federighi. If you love your Pencil, thank machine learning.

Auf dem iPhone wird das maschinelle Lernen dadurch ermöglicht, dass Apple einen dynamischen Cache von ca. 200MB auf dem Gerät belegt, je nachdem wieviele persönliche Daten gespeichert werden.

Sie sehen gerade einen Platzhalterinhalt von Facebook. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Instagram. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

0 Kommentare