Apple veröffentlichte heute eine Vorschau auf neue Kinder-Schutzfunktionen, die im Laufe des Jahres mit Software-Updates auf iOS 15, iPadOS 15 und macOS Monterey kommen werden. Das Unternehmen teilte mit, dass die Funktionen zunächst nur in den USA verfügbar sein werden und im Laufe der Zeit auf andere Regionen ausgeweitet werden.

Fotocredit: Apple

Sicherheit in der Kommunikation

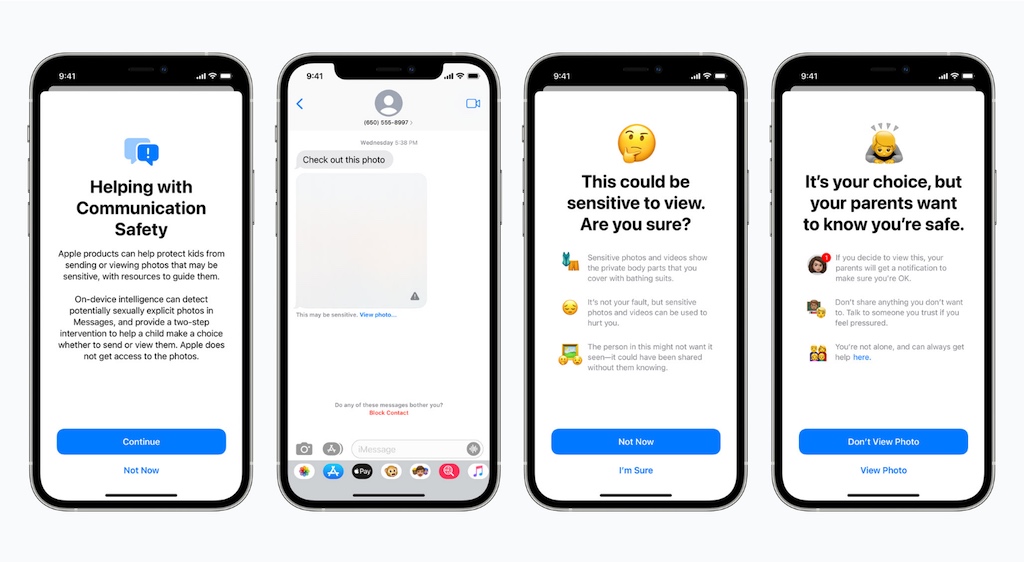

Zunächst wird die Nachrichten-App auf dem iPhone, iPad und Mac eine neue Funktion zur Kommunikationssicherheit erhalten, die Kinder warnt, wenn sie sexuell anstößige Fotos empfangen oder versenden. Apple erklärt, dass die Nachrichten-App maschinelles Lernen auf dem Gerät verwenden wird, um Bildanhänge zu analysieren. Wenn ein Foto als sexuell explizit eingestuft wird, wird das Foto automatisch ausgeblendet und das Kind gewarnt.

Wenn ein Kind versucht, ein als bedenklich gekennzeichnetes Foto in der Nachrichten-App anzusehen, wird es gewarnt. Je nach Alter des Kindes können die Eltern auch eine Benachrichtigung erhalten, wenn ihr Kind das betreffende Foto anschaut oder nach einer Warnung ein freizügiges Foto an einen anderen Kontakt sendet.

Apple sagt, dass die neue Kommunikations-Sicherheitsfunktion in Updates für iOS 15, iPadOS 15 und macOS Monterey später in diesem Jahr für Konten, die als Familien in iCloud eingerichtet sind, erscheinen wird. Apple versichert, dass iMessage-Konversationen mit einer Ende-zu-Ende-Verschlüsselung geschützt bleiben, so dass private Kommunikation von Apple nicht gelesen werden kann.

Scannen nach kinderpornografischen Bildern (CSAM)

Apple wird zudem ab diesem Jahr mit iOS 15 und iPadOS 15 in der Lage sein, bestimmte kinderpornografische Bilder (Child Sexual Abuse Material, CSAM) in iCloud-Fotos zu erkennen. So dass Apple diese Fälle an das National Center for Missing and Exploited Children (NCMEC), eine gemeinnützige Organisation, die mit den amerikanischen Strafverfolgungsbehörden zusammenarbeitet, melden kann.

Apple gibt an, dass seine Methode zur Erkennung bekannter CSAM mit Blick auf die Privatsphäre der Nutzer entwickelt wurde. Anstatt Bilder in der Cloud zu scannen, wird das System laut Apple einen Abgleich mit einer Datenbank bekannter CSAM-Bilder durchführen, die von der NCMEC und anderen Kinderschutzorganisationen zur Verfügung gestellt wird. Apple wird diese Datenbank in einen unlesbaren Satz von Hashes umwandeln, der sicher auf den Geräten der Nutzer gespeichert wird.

Die Hash-Technologie, NeuralHash genannt, analysiert ein Bild und wandelt es in eine eindeutige Nummer um, die für dieses Bild spezifisch ist. Apple erklärt:

„Der Hauptzweck des Hashes ist es, sicherzustellen, dass identische und visuell ähnliche Bilder den gleichen Hash ergeben, während Bilder, die sich voneinander unterscheiden, unterschiedliche Hashes ergeben. Ein Bild, das zum Beispiel leicht beschnitten, in der Größe verändert oder von Farbe in Schwarz-Weiß umgewandelt wurde, wird identisch mit dem Original behandelt und hat denselben Hash.“

Die zugrundeliegende Technologie hinter Apples Methode zur Erkennung bekannter CSAM-Übereinstimmungen ist recht komplex. Begleitend zur Ankündigung hat Apple eine technische Zusammenfassung mit weiteren Details veröffentlicht. Unter anderem erklärt Apple, dass seine Methode zur Erkennung bekannter CSAM „erhebliche Vorteile für den Datenschutz“ gegenüber bestehenden Techniken bietet:

- Dieses System ist ein effektiver Weg, um bekannte CSAM, die in iCloud Fotos-Konten gespeichert sind, zu identifizieren und gleichzeitig die Privatsphäre der Nutzer zu schützen.

- Als Teil des Prozesses können die Benutzer auch nichts über die Menge der bekannten CSAM-Bilder erfahren, die für den Abgleich verwendet wird. Dadurch wird der Inhalt der Datenbank vor böswilliger Nutzung geschützt.

- Das System ist sehr genau, mit einer extrem niedrigen Fehlerquote von weniger als einem von einer Billion Konten pro Jahr.

- Das System ist wesentlich datenschutzfreundlicher als Cloud-basierte Scans, da es nur Nutzer meldet, die eine Sammlung bekannter CSAM in iCloud-Fotos gespeichert haben.

Sie sehen gerade einen Platzhalterinhalt von Facebook. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Instagram. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

0 Kommentare