Gestern hat Apple neue Schutzmaßnahmen für die Sicherheit von Kindern für iOS, iPadOS und macOS angekündigt. Unter anderem wird die Nachrichten-App Kinder vor sexuell anstößigen Fotos schützen. Weiterhin wird es eine auf den Datenschutz bedachte Scan-Funktion geben, die iCloud-Fotos auf kinderpornografische Inhalte untersucht. Nun stellt Apple klar, wann die Schutzfunktionen in Kraft treten, die zunächst in den USA im Laufe des Jahres eingeführt werden.

Fotocredit: Apple

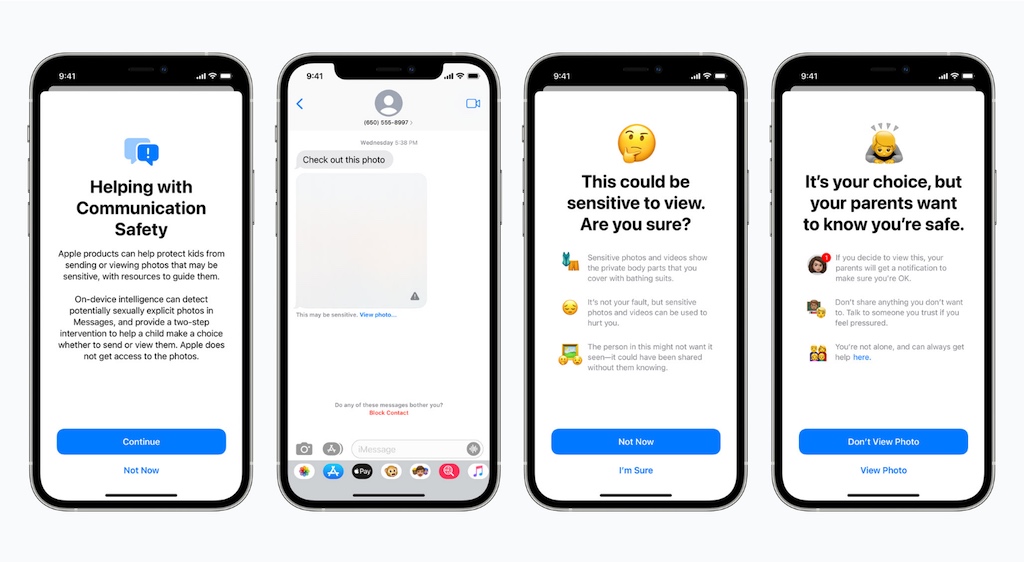

iMessage-Schutz ist nur für Kinder-Konten aktivierbar

Die Nachrichten-App auf dem iPhone, iPad und Mac erhält noch in diesem Jahr eine neue Funktion zur Kommunikationssicherheit, die Kinder warnt, wenn sie sexuell anstößige Fotos empfangen oder versenden. Apple erklärt, dass die Nachrichten-App maschinelles Lernen auf dem Gerät verwenden wird, um Bildanhänge zu analysieren. Wenn ein Foto als sexuell explizit eingestuft wird, wird das Foto automatisch ausgeblendet und das Kind sowie gegebenenfalls die Eltern gewarnt. Apple versichert, dass iMessage-Konversationen mit einer Ende-zu-Ende-Verschlüsselung geschützt bleiben, so dass private Kommunikation von Apple nicht gelesen werden kann.

Wie das Unternehmen weiter ausführt, tritt die Schutzfunktion nur in Kraft, wenn ein Elternteil die Kommunikationssicherheit für den Apple ID Account eines Kindes aktiviert. Die Kommunikationssicherheit kann nicht für Konten von Erwachsenen aktiviert werden und ist somit nur für Nutzer unter 18 Jahren verfügbar. Erwachsene müssen also nicht befürchten, dass ihre Inhalte auf Nacktheit überprüft werden.

Zudem erklärt Apple, dass die elterlichen Benachrichtigungen optional und nur verfügbar sind, wenn das Kind, welches das Foto betrachtet, unter 13 Jahre alt ist. Eltern können nicht benachrichtigt werden, wenn ein Kind zwischen 13 und 17 Jahren ein sexuell explizit Foto erhält. Das Foto bleibt jedoch weiterhin im Chat ausgeblendet, wenn die Kommunikationssicherheit aktiviert ist.

Fotos-Überprüfung nur in iCloud-Fotos

Apple wird zudem ab diesem Jahr mit iOS 15 und iPadOS 15 in der Lage sein, bestimmte kinderpornografische Bilder (Child Sexual Abuse Material, CSAM) in iCloud-Fotos zu erkennen. So dass Apple diese Fälle an das National Center for Missing and Exploited Children (NCMEC) melden kann.

Wie Apple versichert, ist das System auf den Datenschutz bedacht. Anstatt Bilder in der Cloud auf bestimmte Merkmale zu scannen, wird das System einen Hash-Abgleich mit einer Datenbank bekannter CSAM-Bilder durchführen, die von der NCMEC und anderen Kinderschutzorganisationen zur Verfügung gestellt wird. Die Hash-Technologie, NeuralHash genannt, analysiert ein Bild und wandelt es in eine eindeutige Nummer um, die für dieses Bild spezifisch ist. Die Werte werden anschließend verglichen. Der Hauptzweck des Hashes ist es, sicherzustellen, dass identische und visuell ähnliche Bilder den gleichen Hash ergeben, während Bilder, die sich voneinander unterscheiden, unterschiedliche Hashes ergeben.

Das Scannen von CSAM-Bildern ist keine optionale Funktion und geschieht automatisch. Es ist wichtig anzumerken, dass Apple speziell nach Hashes bekannter Materialien über sexuellen Kindesmissbrauch sucht und nicht die Fotobibliothek eines Nutzers auf bestimmte Merkmale untersucht. Dennoch können Nutzer, die Datenschutz-Bedenken wegen Apples Bemühungen haben, iCloud-Fotos deaktivieren. So bestätigt MacRumors, dass bekannte CSAM-Bilder nicht erkannt werden können, wenn die iCloud-Fotos-Funktion ausgeschaltet ist. Apple hat außerdem bestätigt, dass bekannte CSAM-Bilder in iCloud-Backups nicht erkannt werden können, wenn iCloud-Fotos auf dem Gerät eines Benutzers deaktiviert ist.

Sie sehen gerade einen Platzhalterinhalt von Facebook. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Instagram. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

0 Kommentare