Seit Apple die neuen Schutzfunktionen für die Sicherheit von Kindern vorgestellt hat, gehen die Meinungen auseinander. Während einige glauben, dass die zunächst in den USA eingeführte Schutzmaßnahme eine großartige Sache ist, um Kinder zu schützen, haben andere Datenschutzbedenken. Nun geht Apple mit einem neuen FAQ-Dokument auf die Bedenken ein und erklärt dabei die technische Umsetzung.

Fotocredit: Apple

Apples Schutzfunktionen für Kinder

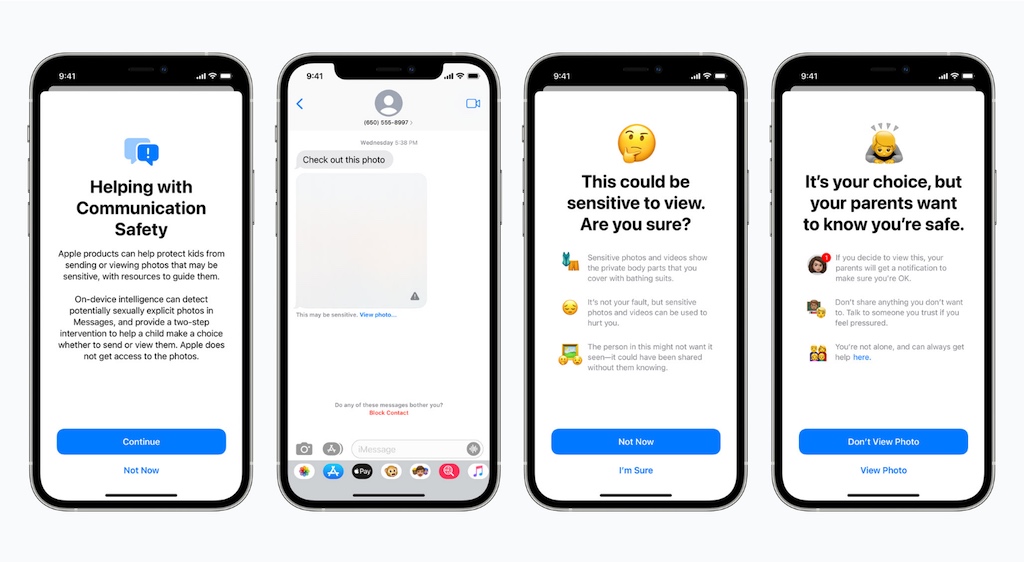

Apple hat vor kurzem eine neue Initiative vorgestellt, die dem Schutz von Kindern dienen soll. Die Initiative „Expanded Protections for Children“ (Erweiterter Schutz für Kinder) besteht aus mehreren Elementen, die jeweils in die wichtigsten Apple-Plattformen integriert werden.

Während eine Nachrichten-Schutzfunktion, die Kinder vor sexuell eindeutiger Bilder bewahren soll, relativ entspannt aufgenommen wird, sorgt derzeit eine weitere Funktion für Diskussionen. So will Apple auch die iCloud-Fotobibliotheken auf kinderpornografische Inhalte (CSAM, Child Sexual Abuse Material) untersuchen, versicherte jedoch bereits bei der Ankündigung, dass man hierbei großen Wert auf den Datenschutz legt.

Die Bedenken der Nutzer beziehen sich größtenteils auf den Datenschutz und wie das System ausgenutzt werden könnte. In einer neuen FAQ geht Apple auf diese Bedenken ein und verdeutlicht den Unterschied zwischen den beiden neuen Funktionen.

Bezüglich des Nachrichten-Schutzes schreibt Apple:

„Die Kommunikationssicherheit in der Nachrichten-App soll Eltern und Kindern zusätzliche Werkzeuge an die Hand geben, um ihre Kinder vor dem Senden und Empfangen sexuell eindeutiger Bilder in der Nachrichten-App zu schützen. Sie funktioniert nur für Bilder, die in der Nachrichten-App für Kinder-Konten gesendet oder empfangen werden, die in der Familienfreigabe eingerichtet sind. Sie analysiert die Bilder auf dem Gerät und ändert daher nicht die Datenschutzbestimmungen der Nachrichten-App. Wenn ein Kinderkonto sexuell eindeutige Bilder sendet oder empfängt, wird das Foto unscharf dargestellt und das Kind gewarnt. Das Kind erhält hilfreiche Ressourcen und wird darauf hingewiesen, dass es in Ordnung ist, wenn es das Foto nicht ansehen oder senden möchte. Als zusätzliche Vorsichtsmaßnahme können jüngere Kinder auch darauf hingewiesen werden, dass ihre Eltern eine Nachricht erhalten, wenn sie das Foto doch ansehen, um ihre Sicherheit zu gewährleisten.“

Im direkten Vergleich erklärt Apple den CSAM-Scan:

„Die zweite Funktion, die CSAM-Erkennung in iCloud-Fotos, soll CSAM von iCloud-Fotos fernhalten, ohne Apple Informationen über andere Fotos als die zu liefern, die mit bekannten CSAM-Bildern übereinstimmen. Der Besitz von CSAM-Bildern ist in den meisten Ländern, auch in den USA, illegal. Diese Funktion wirkt sich nur auf Nutzer aus, die iCloud-Fotos zum Speichern ihrer Fotos verwenden. Sie wirkt sich nicht auf Benutzer aus, die iCloud-Fotos nicht verwenden möchten. Es gibt keine Auswirkungen auf andere Daten auf dem Gerät. Diese Funktion gilt nicht für die Nachrichten-App“

Wie Apple versichert, ist das System auf den Datenschutz bedacht. Die CSAM-Erkennung führt einen Hash-Abgleich mit einer Datenbank bekannter CSAM-Bilder durch. Die Hash-Technologie analysiert hierbei ein Bild und wandelt es in eine eindeutige Nummer um, die für dieses Bild spezifisch ist. Die Werte werden anschließend mit der Datenbank verglichen. So lassen sich die gesuchten Bilder erkennen, ohne dass sie auf spezielle Merkmale untersucht werden müssen. Wird eine bestimmte Anzahl von Übereinstimmungen festgestellt erfolgt eine weitere Prüfung.

Das System wird ausschließlich für das Aufspüren von CSAM eingesetzt

Apple räumt auch Bedenken aus, dass die Ende-zu-Ende-Verschlüsselung durch die neuen Schutzfunktionen unterbrochen werden könnte. Die größte Sorge einiger Nutzer ist die mögliche Anordnung einer Regierung, das System anzupassen, um andere Arten von Vergehen zu untersuchen. Apple erklärt diesbezüglich:

„Apple wird solche Forderungen zurückweisen. Apples CSAM-Erkennungsfunktion ist ausschließlich darauf ausgelegt, bekannte CSAM-Bilder zu erkennen, die in iCloud-Fotos gespeichert sind und von Experten des NCMEC [National Center for Missing & Exploited Children] und anderen Kinderschutzgruppen identifiziert wurden. Wir waren schon früher mit Forderungen konfrontiert, staatlich verordnete Änderungen zu entwickeln und zu implementieren, die die Privatsphäre der Nutzer beeinträchtigen, und haben diese Forderungen standhaft abgelehnt. Wir werden sie auch in Zukunft ablehnen. Um es klar zu sagen: Diese Technologie ist auf die Erkennung von in iCloud gespeicherten CSAM beschränkt, und wir werden keiner Aufforderung einer Regierung nachkommen, sie zu erweitern. Außerdem führt Apple eine menschliche Überprüfung durch, bevor eine Meldung an die NCMEC erfolgt. In einem Fall, in dem das System Fotos markiert, die nicht mit bekannten CSAM-Bildern übereinstimmen, würde das Konto nicht deaktiviert und kein Bericht an das NCMEC eingereicht werden.“

Sie sehen gerade einen Platzhalterinhalt von Facebook. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von Instagram. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr InformationenSie sehen gerade einen Platzhalterinhalt von X. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Mehr Informationen

0 Kommentare